I sistemi di raccomandazione, o algoritmi di raccomandazione, sono onnipresenti in qualsiasi sito o servizio mediamente evoluto. Con conseguenze dirompenti, e non sempre positive, sulla nostra vita.

Alzi la mano chi non è mai incappato in un suggerimento su un sito di shopping, su un trending topic o su un post ampiamente condiviso e si è chiesto perché vedo questa roba?

La risposta è semplice: algoritmi di raccomandazione. I sistemi di raccomandazione sono ampiamente usati, dai servizi maggiori ma anche quelli minori (anche questo sito ne ha uno a fondo pagina che suggerisce altri articoli potenzialmente interessanti).

I motori di raccomandazione sono ovunque

Una premessa: questa riflessione, come accade spesso, non è farina del mio sacco, ma è ampiamente riportata da questo interessante articolo di Wired USA, che spiega, in modo semplice e chiaro, il funzionamento, e soprattutto i limiti, degli algoritmi di raccomandazione. Consiglio a chiunque mastichi l’inglese di leggere l’originale, ma ne riporto qui un sunto dei concetti fondamentali. Per comodità, la “narrazione” dell’articolo originale ha uno sfondo diverso. Il resto sono mie considerazioni

Il primo problema degli algoritmi di raccomandazione è che tendono all’autoreferenzialità

Tutto parte dall’autore che nota un libro quantomeno peculiare indicato fra quelli “caldi” suggeriti da Amazon. Le vendite si sono impennate quando il libro è finito nel carosello dei suggeriti, il che ha portato una crescita dell’interesse e così via.

Beh, questo è abbastanza semplice da capire: quando un prodotto o un tema diventano trending, vengono mostrate a più persone. Il che ne aumenta le possibilità di essere visualizzato. Il che aumenta le discussioni in merito. Visualizzazioni, discussioni e feedback sono i tre pilastri degli algoritmi di raccomandazione di questo tipo. Questa è una debolezza notevole, perché una volta entrati, si crea un circolo di crescita praticamente esponenziale. E lo sforzo marginale per rimanerci , specie se si tratta di prodotti, è relativamente basso.

“Everywhere you look, recommendation engines offer striking examples of how values and judgments become embedded in algorithms and how algorithms can be gamed by strategic actors.“

“Ovunque guardi, i motori di raccomandazione offrono esempi lampanti di come valori e giudizi vengono inclusi negli algorimti e come gli algorimi possono essere manipolati dagli attori strategici”

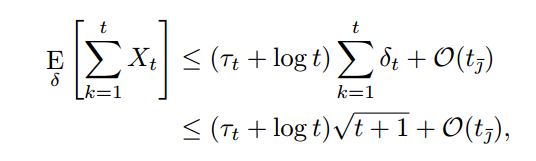

Il secondo problema dei motori di raccomandazione è che sono imprecisi

Uno dei sistemi di raccomandazione più diffusi è basarsi su quello che le persone “come noi” hanno letto, guardato o acquistato. Ma cosa significa esattamente “come noi”? Si tratta di una questione di età, genere, razza? Gente con gli stessi interessi? Che ci somiglia fisicamente? O piuttosto si tratta delle nostre “fattezze digitali” basate sui dati granulari che i diversi sistemi raccolgono su di noi e poi dati in pasto a un sistema di machine learning?

Insomma, le persone come noi, sono semplicemente persone con una impronta digitale simile alla nostra. Il che spesso si riduce a quelle accettabilmente simili, che è un modo carino per dire che i sistemi prendono su i dati più simili che hanno. Non serve avere un dottorato di ricerca in statistica per capire che in mancanza d’altro, useranno dati con pochissime cose in comune.

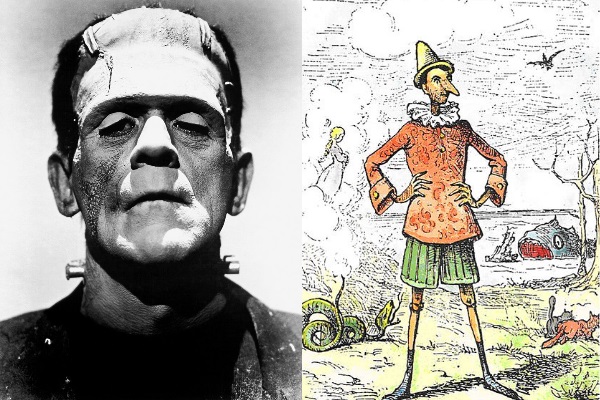

Il terzo (e più grave) problema è che gli algoritmi di raccomandazione favoriscono gli stereotipi

“Deep down, behind every “people like you” recommendation is a computational method for distilling stereotypes through data.“

“Scavando a fondo, dietro ogni algoritmo del tipo “le persone come te”, c’è un metodo computazionale per distillare stereotipi attraverso i dati.

Ricordiamo un concetto fondamentale: gli algoritmi non sono nostri amici, sono macchine pensate per massimizzare il ricavo. E per ragioni meramente statistiche, tenderanno sempre a proporci quello che “il mercato” sembra volere. Quello che cambia è la dimensione della nicchia che viene presa come riferimento, a seconda di quanti dati abbiamo già regalato al sistema di profilazione.

Il passaggio successivo è meramente logico: “statisticamente probabile” e “stereotipo” sono simili in maniera preoccupante, quantomeno nelle logiche di mercato.

La prova, possiamo averla tutti i giorni, e ne ho già parlato quando suggerivo di ingannare gli algoritmi quando prepariamo un computer per “anziani” o per utenti poco esperti. Basta avviare un processo di selezione per fare in modo di ricevere quasi solo suggerimenti provenienti dalla nicchia di riferimento. Oppure (peggio ancora) un mix delle nicchie di riferimento calcolate e di temi “caldi” scelti sulla base di parametri estremamente volatili.

Infine, gli algoritmi di raccomandazione privilegiano il sensazionalismo

“…most trending-type recommendation algorithms employ a logic that filters out common terms as background noise and highlights those that have acceleration and velocity on their side.”

“…molti algoritmi di raccomandazione basati sui trend usano una logica che filtra i termini comuni come rumore di fondo e mettono in evidenza quelli che hanno accelerazione e velocità dalla loro parte”

Il problema è che questo seppellisce di fatto qualsiasi tipo di conversazione che abbia un grande volume costante nel tempo. Per esempio nel caso della cronaca i problemi costanti come la salute, il welfare, l’impiego, pur essendo oggetto di moltissime conversazioni, lasciano ampio spazio agli eventi più rari, che ottengono una copertura sproporzionata.

Ironicamente, osserva l’autore, questo è un problema in comune con la carta stampata. Come a dire che di tutto quello che i nuovi media potevano ereditare da quelli tradizionali, hanno preso il peggio.

La parte peggiore è che questo tipo di algoritmi di raccomandazione è estremamente debole e manipolabile.

Il problema di usare l’accelerazione mediatica come valore è che è fin troppo semplice manipolare l’algorimo. Un hashtag o una notizia condivisi dal giusto numero di persone in un tempo sufficientemente rapido, diventeranno virali con molta facilità. Alcuni attivisti di diverse aree hanno già imparato a mettere in pratica questa strategia, preparando interventi con lo stesso hashtag (nell’ambito di Twitter) e postandoli in modo coordinato.

Ma se funziona per Twitter, perché non dovrebbe funzionare anche in altri ambiti? Se per esempio cinquemila fan di un autore (o diecimila attivisti di qualche schieramento) si coordinano per effettuare lo stesso acquisto su Amazon nello stesso momento, quale può essere l’accelerazione conferita al prodotto acquistato?

Una domanda più che lecita perché, se davvero bastasse qualche migliaio di transazioni, “finanziare” un acquisto coordinato potrebbe essere un investimento strategico più efficace di quelli tradizionali.

La soluzione? Rendere gli algoritmi di raccomandazione più trasparenti. O eliminarli del tutto.

Grandi problemi ed enormi limiti, che tuttavia hanno soluzioni piuttosto semplici. Le aziende sono molto gelose del funzionamento dei loro algoritmi. Il sospetto che tale riservatezza nasconda il timore che possa crollare il castello di carte è più che lecito. Se ci fosse più trasparenza nell’indicazione di quello che è “trending” o “consigliato”, sarebbe più semplice per chi vede le proposte decidere cosa fare.

Così come sarebbe quantomeno doveroso, nelle piattaforme in cui sono possibili le sponsorizzazioni, che il sistema mostrasse in chiaro che percentuale della copertura del contenuto è stata a pagamento. Una specie di “certificato di nascita” che di permetta di capire se stiamo vedendo un determinato contenuto per la sesta volta perché è davvero interessante oppure perché qualcuno lo sta sponsorizzando di continuo.

L’alternativa più radicale, ma anche più semplice, sarebbe quella di eliminare gli algoritmi di raccomandazione. Ormai è chiaro che il loro funzionamento lascia molto a desiderare, e spesso non piacciono agli utenti, come dimostra il recente passo indietro di Twitter verso il semplice sistema cronologico.

Il tutto avrebbe almeno due vantaggi: il primo verso l’utente. Ammettiamolo, vedere sempre le stesse cose sapendo che una piattaforma contiene una varietà quasi infinita di contenuti è frustrante. Il secondo vantaggio sarebbe economico: invece di spendere risorse ad inseguire un sistema di raccomandazione scadente ma sempre più complesso e oneroso in termini di calcolo, si potrebbero abbattere i costi, aumentando i margini ed evitando di dovere elaborare sistemi di raccomandazione sempre più stingenti che consumano più risorse senza un reale incremento dell’efficacia. Oggi infatti le aziende investono sulla speranza che un giorno gli algoritmi inizino a funzionare sul serio.

Cosa che però sembra ogni giorno più improbabile, alla luce dei continui problemi di privacy, uso antietico dei dati e fughe di informazioni che quotidianamente minano i servizi che fanno maggiore uso degli algoritmi di raccomandazione.